Тема для легкого обсуждения тем, связанных с процессорами. Тут можно пофлеймить, и в меру поругаться.

ТУТ УДАЛЯЮТСЯ: мат, тяжелые личные оскорбления (в т.ч. родственников), угрозы в реальной жизни, обсуждение ботоводства, переписка с модераторами, оффтопик, посвященный политическим вопросам (п. 4.3.7.2).

Raytracer77: CPU-флудилка. Здесь фанаты могут отвести душу. (часть 8)

| Raytracer77 Member Автор темы 29059/69288 ответов, #45 в рейтинге 12 лет на iXBT, с августа 2012 Чаще пишет в "Процессоры" (41%) Россия, Новороссийск-Москва |

| vadim.it Member | TbILI Прошлого поколения? Вон АМД выпустила +5% производительности ценой -30% энергопотребления, вой в сети до сих пор не улегся. Потребитель это не оценил, и процессоры рынок не принял ну и понятно что многие ждали встройку более менее ("на всякий случай"), но зато с лучами и тензорами 40+ TOPS (для "win 11 сopilot support") а по факту AM5 обвязка сама по себе конь (мат платы + DDR5), а уж соответствующие APU так и ваще нифига не бюджетно P.S.: кстате, тензоры только для инференса подходят или для обучения/до обучения AI моделей тоже ? |

| Saturn Member 9636/88393 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California | если скажем речь идет про Intel AMX то он предоставляет или int8 или bf16 https://www.intel.com/content/www/us/en/developer/ar…rence-on-amx.html поэтому обычно говорят про inference, но с bf16 можно и обучать |

| Чатланин Member |

| vadim.it Member |

| Saturn Member 9637/88394 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California |

| bess_temporary Advanced Member 19570/19805 ответов, #1 в рейтинге 7 лет на iXBT, с января 2018 1 фото на iXBT.photo Чаще пишет в "Процессоры" (98%) Россия, iXBT.com c 1997 г. |

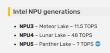

| vadim.it Member | Saturn AMX ускоряет маленькие вещи в 3 раза, большие вещи типа Llama 3.1 405B тоже ускоряет но не так сильно так модуль NPU в новых процессорах Intel и AMD - это и есть AMX, или что о другое ? NPU5 in Panther Lake https://videocardz.com/newz/intel-confirms-5th-gen-n…-for-panther-lakeну NPU же есть в некоторых новых райзенах, тогда зачем же ещё и AMX ? (если это не оно) К сообщению приложены файлы: |

| bess_temporary Advanced Member 19572/19807 ответов, #1 в рейтинге 7 лет на iXBT, с января 2018 1 фото на iXBT.photo Чаще пишет в "Процессоры" (98%) Россия, iXBT.com c 1997 г. | vadim.it > ну NPU же есть в некоторых новых райзенах, тогда зачем же ещё и AMX ? (если это не оно) Это нисколько не оно. NPU - это отдельный блок, а AMX - машинные инструкции CPU. Честно скажу, не знаю, в каких пропорциях нужны отдельные блоки, а в каких - инструкции. Кстати, NPU и AMX живут в разных процессорах. NPU есть в потребительских, у обеих компаний. А AMX - только в серверных и только у Интела. Кстати, там ещё и акселераторы есть в виде отдельных блоков. |

| vadim.it Member | bess_temporary Кстати, там ещё и акселераторы есть в виде отдельных блоков. где чего, какие акселераторы ? bess_temporary Кстати, NPU и AMX живут в разных процессорах. NPU есть в потребительских, у обеих компаний. А AMX - только в серверных и только у Интела. так выходит что NPU только для инференса и на нём нельзя обучать / до обучать AI модели ? есть какие то подробности ? |

| ConstWilD Member 1646/4436 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков | Saturn AMX ускоряет маленькие вещи в 3 раза, большие вещи типа Llama 3.1 405B тоже ускоряет но не так сильно Хотел бы я посмотреть на таких "альтернативно одаренных разумом" индивидуумов, которые будут обучать свои нейронки чисто на AMX? ИМХО, таких в природе не будет. На фоне цен на системы с ЦП имеющими AMX, цены за RTX 4090/5090 будут казаться просто даром. Обучение нейронок на RTX 4090 будет обходить обучение на ЦП с AMX, ИМХО в разы, а то и на порядки. Про проф ускорители я промолчу. |

| bess_temporary Advanced Member 19574/19809 ответов, #1 в рейтинге 7 лет на iXBT, с января 2018 1 фото на iXBT.photo Чаще пишет в "Процессоры" (98%) Россия, iXBT.com c 1997 г. | vadim.it > так выходит что NPU только для инференса и на нём нельзя обучать Это не ко мне, я по другому профилю > где чего, какие акселераторы ? Темнота! Исправлено: bess_temporary, 06.10.2024 22:42 К сообщению приложены файлы: |

| Saturn Member 9638/88396 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California | ConstWilD Хотел бы я посмотреть на таких "альтернативно одаренных разумом" индивидуумов, которые будут обучать свои нейронки чисто на AMX? ну а если данные для модели не лезут в VRAM - ваши опции? Добавление от 06.10.2024 22:45: ConstWilDНа фоне цен на системы с ЦП имеющими AMX самый дешевый проц с AMX - за $400 грубо говоря https://en.wikipedia.org/wiki/Sapphire_Rapids но у вас есть опция не платить за оный - все будет ехать медленнее, зато деньги сэкономил Добавление от 06.10.2024 22:48: ConstWilDОбучение нейронок на RTX 4090 будет обходить обучение на ЦП с AMX, ИМХО в разы, а то и на порядки. раз в 20 будет быстрее, ну а если без AMX - ну будет в 40 раз быстрее чем на CPU но мы же не про печаль типа ("Обучение нейронок на RTX 4090") |

| ConstWilD Member 1647/4437 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков | Saturn ну а если данные для модели не лезут в VRAM - ваши опции? Если не лезет, то собирать кластер из ускорителей, а какой еще вариант? И можно пример маленьких вещей из AMX ускоряет маленькие вещи в 3 раза , которые не влазят в 24 ГБ VRAM RTX 4090. самый цешевый проц с AMX - за $400 грубо говоря Ок, ЦП я нашел w3-2425 6 (12) 3.0 4.2 4.4 15.0 MB 130 W 156 W $529А система на таком ЦП сколько будет стоить? От $1,5 К за минимальную комплектацию или выше? Вопрос на сколько w3-2423 будет уступать RTX 4090, в обучении нейронок - в 100 раз или больше? |

| bess_temporary Advanced Member 19576/19811 ответов, #1 в рейтинге 7 лет на iXBT, с января 2018 1 фото на iXBT.photo Чаще пишет в "Процессоры" (98%) Россия, iXBT.com c 1997 г. | ConstWilD А система на RTX 4090 сколько будет стоить? И что она ещё умеет P.S. Узкий специалист подобен флюсу (c) |

| ConstWilD Member 1648/4438 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков |

| Saturn Member 9639/88397 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California | ConstWilD Вопрос на сколько w3-2423 будет уступать RTX 4090, в обучении нейронок Ну так вопрос каких нейронок... Скажем и 7 лет назад и 4 года назад на работе модели обучали на CPU. На GPU тогда было 3xGV100, только для inference уже сделанной модели. Не надо делать очень громких и обобщающих заявлений. |

| ConstWilD Member 1649/4439 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков | bess_temporary А система на RTX 4090 сколько будет стоить? РТХ 4090 можно добавить в любой ПК с хорошим БП. Хоть на селероне. P.S. Узкий специалист подобен флюсу (c) Только почему то весь мир идет по направлению узкой специализации. По проблемам лечения флюса, я пойду к "узкому специалисту", а не терапевту широкого профиля. Saturn Скажем и 7 лет назад и 4 года назад на работе модели обучали на CPU. Ну когда-то давно мы игрались в 3Д чисто на процессоре, но как-то отказались от этого. |

| vadim.it Member |

| Saturn Member 9640/88398 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California | ConstWilD И можно пример маленьких вещей из AMX ускоряет маленькие вещи в 3 раза , которые не влазят в 24 ГБ VRAM RTX 4090. это не пример AMX, но как пример "маленькости 24GB VRAM" идем на страничку flux 1.dev: https://huggingface.co/black-forest-labs/FLUX.1-dev смотрим на Python code, видим там маааленькую строчку pipe.enable_model_cpu_offload() #save some VRAM by offloading the model to CPU. Remove this if you have enough GPU power без нее модель слопает 37 GB VRAM, и естественно - рухнет на 4090итак - под куполом цирка Flux 1.Dev с этой строчкой и без нее на одной и той же карте RTX 6000 Ada: без строчки - одна картинка генерируется 37 sec, и тут же начинает генерировать вторую жрет 37GB VRAM с этой строчкой - одна картинка генерится (progress bar едет) 45 что ли секунд... а потом "система просирается" еще примерно столько же времени, то есть между одним едущим progress bar и следующим progress bar зазор сравнимый с временем самого progress bar, в итоге времени тратится просто в 2 раза больше жрет < 24GB VRAM P.S. "система просирается" - "не самое технически точное описание процессов в электронике", знаю Добавление от 06.10.2024 23:13: и это уже такой вот inference в 2024-м |

| vadim.it Member |

| bess_temporary Advanced Member 19577/19812 ответов, #1 в рейтинге 7 лет на iXBT, с января 2018 1 фото на iXBT.photo Чаще пишет в "Процессоры" (98%) Россия, iXBT.com c 1997 г. | ConstWilD > Только почему то весь мир идет по направлению узкой специализации. Нет. Мир идёт по обоим направлениям - универсальным и узким. Дантист, уролог и онколог не излечат меня от всех болезней, даже от гриппа не излечат. Их даже может не оказаться в нужное время в нужном месте и за нужные деньги - а терапевт окажется. Тенденция всего лишь состоит в том, что специализированные решения (в компьютерной сфере) развиваются быстрее - ну так это просто эффект быстрой базы. > По проблемам лечения флюса Лечиться надо от всех болезней, а не только от флюса (компьютерная аналогия применительно к врачам подразумевает, что мы больны многими разными болезнями) |

| Saturn Member 9641/88399 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California |

| ConstWilD Member 1650/4440 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков |

| ultrasilent Member 1982/44759 ответов, #18 в рейтинге 18 лет на iXBT, с апреля 2007 94 фото на iXBT.photo Чаще пишет в "ДК плееры" (20%) Латвия |

| Saturn Member 9642/88400 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California | ConstWilD Т.е. по вашему обучение нейронок на w3-2423, будет всего лиш в 20 раз медленней чем на RTX 4090? 20 раз - это разница в inference между Llama на RTX 6000 Ada и W7-3465X без включения AMX, как помню, пока лезет и там и сям, как только не лезет в VRAM - ну... начинается урезка битности и модель, процитирую себя "Нести херню" - не самое технически точное описание процессов в электронике потом и резка битности не помогаетДобавление от 06.10.2024 23:24: vadim.itсколько млрд параметров не очень много - должно было влезать в один GV100 с его блистательными 16GB VRAM, и чтобы еще было место для данных что летели туда-сюда Добавление от 06.10.2024 23:30: ConstWilDОК, пример понял. видно не поняли - дело не в том как быстро работает на Xeon вот сейчас, а то что "как быстро работает" (даже на GPU) - вообще недоопределенное выражение, вот разница в 2 раза по времени, а делов - на одну строчку потом такие же вопросы на Xeon - что можно ускорить на AMX прям сейчас, а что - нет но Llama 3.1 405B занимая 750GB RAM в Xeon лезет, а в VRAM - не влезет даже в пачку ну скажем в 4x4090 |

| ConstWilD Member 1651/4441 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков | Saturn в мой не влезла А корпус поменять нельзя было? Нормальные корпуса, куда влазит РТХ 4090, начинаются от 60 евро. Или это какой то одноюнитный сервак? Или готовый фирменный ПК? bess_temporary Их даже может не оказаться в нужное время в нужном месте и за нужные деньги - а терапевт окажется. Ну если в быть в е....., без денег, без страховки и знания обстановки/окружения, то можно помереть от простого поноса. На планете Земля, врачи есть не везде. В Европе, проблем с доступом к врачам при критических случаях, пока слава богу нет. Врачи еще есть, и при резких обострениях, при том же флюсе - лечат. |

| bess_temporary Advanced Member 19578/19813 ответов, #1 в рейтинге 7 лет на iXBT, с января 2018 1 фото на iXBT.photo Чаще пишет в "Процессоры" (98%) Россия, iXBT.com c 1997 г. | Как-то глубоко и всерьёз вы влезли во врачебную аналогию, позабыв о процессорах |

| ConstWilD Member 1652/4442 ответов, #44 в рейтинге 23 года на iXBT, с марта 2002 Чаще пишет в "Процессоры" (38%) Украина, Харьков | Saturn вот разница в 2 раза по времени, а делов - на одну строчку да хоть на одну команду. Проблема оптимизации задачи под имеющееся железо, была есть и будет. "У кого суп жидкий, у кого жемчуг мелкий!". но Llama 3.1 405B занимая 750GB RAM Э вроде w3-2423 4-х канальный, если набивать 256 ГБ модулями M321RBGA0B40-CWK то как то не очень гуманно будет. M321RBGA0B40-CWK в Европе от 3700 евро за планку. |

| Saturn Member 9643/88401 ответов, #9 в рейтинге 22 года на iXBT, с ноября 2002 6 фото на iXBT.photo Чаще пишет в "Фото" (32%) США, California | ConstWilD А корпус поменять нельзя было? обещали что влезет в любой - а оказалось что нет, ай-яй Добавление от 06.10.2024 23:47: ConstWilDИли Flux 1.Dev вообще тупо не будет работать на одном ЦП? будет работать на CPU, конечно, просто некоторые не верят что таким делом можно вообще заниматься Добавление от 06.10.2024 23:49: ConstWilDЭ вроде w3-2423 4-х канальный, если набивать 256 ГБ модулями M321RBGA0B40-CWK вам нужен дешевый процессор - или дешевый объем памяти? ну вот мне хотелось скорее память поэтому взял 8-канальный с 16-ю планками |

Если Вы считаете это сообщение ценным для дискуссии (не обязательно с ним соглашаться), Вы можете поблагодарить его автора, а также перечислить ему на счет некоторую сумму со своего баланса (при отзыве благодарности перечисленная сумма не будет вам возвращена).

Также вы можете оценить сообщение как неудачное.

В течение суток можно 20 раз оценить сообщения разных участников (купите Premium-аккаунт, либо оплачивайте оценки сверх лимита).